«Come è possibile che il cervello, in apparenza così solido, sia il supporto di cose tanto impalpabili come i pensieri?». La domanda che Marvin Minsky si pone all’inizio del suo celebre libro La società della mente è, in un certo senso, la domanda che, oltre a scatenare un dibattito molto acceso su tutta una serie di questioni che abbracciano filosofia, psicologia, linguistica, ha “certificato” nel 1985, anno di uscita del libro, trent’anni di ricerche sull’intelligenza artificiale e sul tentativo di riprodurre una facoltà tipicamente umana: il pensiero.

La recente scomparsa di Minsky, avvenuta nel gennaio del 2016 all’età di 88 anni, non è passata inosservata. Minsky faceva parte di quel manipolo di personaggi, veramente straordinari e anche un po’ “pazzi”, che hanno segnato la storia della tecnologia contemporanea e che fanno tornare alla mente tutto quello che è stato fatto, allora, e del quale oggi quasi non ci accorgiamo quando usiamo un telefono, un tablet, un computer o quando un medico usa la chirurgia robotica o un pilota si addestra con un simulatore di volo.

Procediamo con ordine: andiamo, per un momento, ad uno straordinario periodo della storia tecnologica: siamo nel 1955. Il termine “informatica” non è stato ancora nemmeno pensato, anche se gli ultimi periodi sono stati molto intensi per quanto attiene lo sviluppo tecnologico.

Gli anni precedenti erano stati, infatti, densi di spettacolari conquiste: Alan Turing, dopo aver formalizzato il concetto di “algoritmo”, fondamentale per la scienza dei calcolatori, e aver ideato il test che prende il suo nome, indispensabile per i futuri studi sull’intelligenza artificiale, scompare tragicamente nel 1954.

John von Neumann, il cosiddetto genio del male[1], rielaborando le idee di Turing del 1936 sulla realizzazione di una cosiddetta “macchina universale”, concepisce l’EDVAC (Electronic Discrete Variables Automatic Computer), la prima macchina digitale programmabile (quindi con un programma memorizzato), basata su quella che sarà poi definita la celebre “architettura di von Neumann”, un importante schema logico-funzionale che ancora oggi guida la realizzazione dei moderni computer, anche se allora l’ampiezza della sua memoria era di appena 5.5 Kilobyte.

Dicevamo, siamo nel 1955. I personaggi in questione sono John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon. Il documento redatto il 31 agosto di quell’anno dai quattro, la cosiddetta “proposta di Dartmouth”, annuncia quelli che gli organizzatori considerano i temi principali del campo di ricerca, tra cui le reti neurali, la teoria della computabilità, la creatività e l’elaborazione e il riconoscimento del linguaggio naturale e propone di incontrarsi l’estate successiva. Le parole originali dei quattro:

“We propose that a 2 month, 10 man study of artificial intelligence be carried out during the summer of 1956 at Dartmouth College in Hanover, New Hampshire. The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it. An attempt will be made to find how to make machines use language, form abstractions and concepts, solve kinds of problems now reserved for humans, and improve themselves. We think that a significant advance can be made in one or more of these problems if a carefully selected group of scientists work on it together for a summer.[2]“

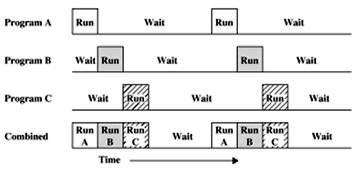

McCarthy (1927-2011), l’inventore del termine “intelligenza artificiale”, è un ingegnere elettronico, autore, tra l’altro, del celebre linguaggio di programmazione Lisp, il più vecchio linguaggio di programmazione ad alto livello ad essere usato ancora oggi, dopo il Fortran. All’inizio degli anni Cinquanta, quando si trovava al MIT, McCarthy aveva ideato il time-sharing, un procedimento, adottato da quel momento in poi dalla maggior parte dei sistemi operativi, attraverso il quale molti utenti possono lavorare contemporaneamente su un singolo computer e senza il quale sarebbe stato difficile immaginare la rete Internet odierna. Da quest’idea è scaturito in seguito il concetto di multitasking, largamente applicato nei sistemi operativi di recente generazione, secondo il quale il sistema operativo può eseguire più programmi contemporaneamente.

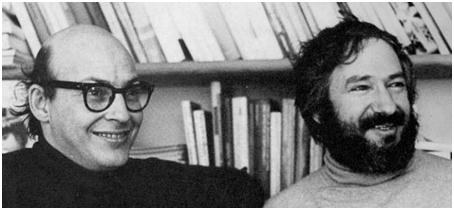

Minsky (1927-2016) si laurea, invece, in matematica ad Harvard con il massimo dei voti nel 1950, ma studia anche fisica, neurofisiologia e psicologia, e dopo aver ottenuto una borsa per dottorato presso la Princeton University, dove realizza il primo simulatore di rete neurale, si trasferisce al Massachusetts Institute of Technology, dove rimarrà per il resto della sua vita. Al MIT fonderà, in seguito, l’Artificial Intelligence Lab e, insieme a Seymour Papert, scriverà pagine importanti per gli studi futuri sull’onnipotenza logica dei calcolatori e, sempre insieme a Papert, creerà il linguaggio Logo, il primo linguaggio di programmazione con scopi didattici.

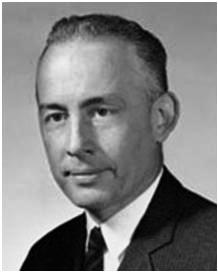

Oltre ad essere uno dei fondatori del movimento del cosiddetto free software, antesignano dell’open source, anche Rochester (1919-2001) è un ingegnere elettronico del MIT.

All’inizio degli anni Cinquanta progetta l’IBM 701, il primo computer commercialmente prodotto della storia; progetta, inoltre, il primo linguaggio assembly simbolico e in seguito darà una mano a McCarthy nella messa a punto del linguaggio LISP.

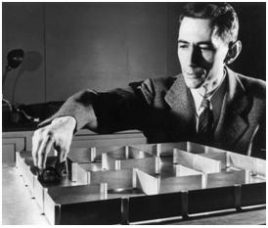

Shannon (1916-2001) è invece un matematico, divenuto celebre per aver posto le basi della teoria dell’informazione.Esperto di crittografia per il governo durante la Seconda Guerra Mondiale, Shannon applica i numeri 0 e 1 della logica booleana ai circuiti elettrici (introducendo così il bit, binary digit, l’unità minima di informazione), e ponendo così le basi teoriche dei sistemi di codificazione, elaborazione e trasmissione digitale dell’informazione. Senza la teoria di Shannon non esisterebbero i CD, i concetti di input e output, e nemmeno la compressione senza perdite dei file (come ad esempio i file .zip), la codifica con perdita (come nei file .mp3) e le modulazioni digitali utilizzate nelle trasmissioni ethernet, e tante altre caratteristiche fondamentali della tecnologia odierna. Nella foto in basso a sinistra, Shannon è con uno dei suoi automi, il topo elettromeccanico Theseus, in grado di “imparare” a trovare la via di uscita in un labirinto, uno dei primi esperimenti di “learning by experience” (1952).

I ‘nostri’ sono anche piuttosto eclettici e creativi: mentre Shannon si diletta di giocoleria, Minsky inventa il microscopio confocale a scansione, predecessore del microscopio confocale a scansione laser, oggi molto diffuso; suona il pianoforte e nel 1968 sarà consulente scientifico della produzione cinematografica di 2001: Odissea nello spazio.

Nel 1956 si tiene la conferenza. Il luogo è il Dartmouth College. L’evento, dal nome “Dartmouth Summer Research Project on Artificial Intelligence” segna ufficialmente la data di inizio degli studi sull’argomento. Da quel momento, si potrebbe dire con una locuzione comune, niente sarebbe stato più lo stesso.

Ai quattro della prima ora si aggiungono, per l’occasione, Ray Solomonoff, Oliver Selfridge, Trenchard More, Arthur Samuel, Allen Newell e Herbert Simon. Senza niente togliere agli altri, Newell e Simon meritano un posto di rilievo: il primo matematico, psicologo e informatico, autore del celebre General Problem Solver; il secondo, futuro premio Nobel per l’economia per i suoi studi sull’organizzazione aziendale. Newell e Simon si divisero, nel 1975, il premio Turing[3].

Durante la conferenza, Newell e Simon presentano il Logic Theorist, il primo programma esplicitamente progetto per imitare le capacità di problem solving degli esseri umani.

La molla, o in un certo senso la provocazione, che spinge il gruppo è appunto il tentativo di dimostrare che ogni aspetto dell’apprendimento umano, ovvero ogni caratteristica dell’intelligenza umana, può essere oggetto di simulazione da parte di una macchina, e dato che in quel momento la macchina per eccellenza è il calcolatore, da parte di un computer. La svolta “cognitivista” in psicologia, che come è noto ha privilegiato gli aspetti logico-simbolici, razionali, computanti della mente umana e ha identificato nel computer un modello di riferimento per tentare di spiegare molti dei processi attraverso i quali l’uomo conosce e ragiona, fa da cornice alla proposta.

Le domande, in questo campo, si moltiplicano: si può parlare di conoscenza attraverso le macchine, come quando esse vengono utilizzate per dispensare informazioni o mediare la comunicazione umana, o anche di conoscenza delle macchine? Che cos’è l’intelligenza? È soltanto manipolazione di simboli, è solo un processo computazionale, in una parola è “calcolo”, come sostengono da sempre molti teorici dell’IA, o è qualcosa di più? E ancora, esiste un’analogia fra cervello e computer? O, almeno, quali aspetti della mente umana possono essere riprodotti da un calcolatore? La macchina esegue in modo infallibile e deterministico una serie definita di istruzioni dettate dall’uomo, e non potrebbe mai prendere l’iniziativa; eppure, chi ha avuto modo di lavorare con un computer sa che esso, talvolta, ci stupisce per la sorprendente velocità con cui opera correlazioni fra dati complessi. E infine, può essere considerato “intelligente” un computer che vince una partita contro il campione del mondo del gioco degli scacchi? Si può produrre, così come viene prodotta un’automobile o un elettrodomestico, una mente artificiale[4]?

Minsky e Papert hanno cercato di spiegare che all’interno del cervello umano è organizzata una miriade di “piccoli agenti” specializzati nell’esecuzione di una singola operazione (mantenimento dell’equilibrio, comprensione del linguaggio, etc.), ma che di per sé non sono intelligenti. L’intelligenza deriva, invece, dalla cooperazione e dall’interazione di questi agenti. A questa visione ha fatto eco il celebre dualismo funzionalista di Hilary Putnam, secondo cui la mente sta al cervello come il programma (software) sta alla macchina (hardware): una visione che aveva una forte influenza comportamentista, secondo la quale l’attenzione non doveva essere posta su che cosa costituisce un sistema, ma su come esso funziona: le differenze tra uomo e macchina potevano essere individuate soltanto dal loro comportamento.

Alla fine, però, il dibattito ha rivelato posizioni sicuramente ideologiche: da un lato una visione materialistica della mente umana, con una sorta di meccanicismo degli stati mentali, dall’altra una concezione che tenta di mettere in evidenza i tratti specifici ed ineliminabili dell’uomo rispetto a qualsiasi congegno.

Forse, occorre tornare alla distinzione, introdotta da John Searle, tra intelligenza artificiale debole e intelligenza artificiale forte. Mentre la prima afferma che il principale aiuto del computer nello studio della mente è quello di darci uno strumento molto potente e preciso nella formulazione e nell’esame di ipotesi, la seconda sostiene che il cervello non è altro che un calcolatore digitale e la mente non è che un programma per calcolatore: ciò ha come conseguenza il fatto che il cervello sia uno tra un numero indefinitamente grande di tipi di hardware in grado di sostenere i programmi che costituiscono l’intelligenza umana. È proprio l’idea di intelligenza artificiale forte ad aver scatenato un putiferio nel dibattito contemporaneo, trasformando alcune ipotesi di lavoro in un dibattito filosofico molto acceso.

Oggi sappiamo che, in fondo, una macchina che sconfigge il campione del mondo di scacchi non può essere considerata intelligente, ma soltanto estremamente veloce nella manipolazione di simboli e l’ambizioso progetto di realizzare un traduttore universale è fallito proprio perché alla macchina manca la nozione di “contesto”, indispensabile per operare una traduzione da una lingua ad un’altra utilizzando uno tra i tanti termini con i quali è possibile tradurre un vocabolo.

Dunque, la capacità di calcolare rapidamente e la manipolazione di simboli non sembrano le sole caratteristiche del pensiero umano; forse, i quattro di Dartmouth e i loro continuatori hanno tenuto troppo in considerazione quegli aspetti della nostra intelligenza che meglio si prestano ad essere sostituiti dalla macchina, come la memoria, la rapidità delle connessioni, il ragionamento logico-formale, etc., ma vi sono altri aspetti del nostro essere umani che non possono essere ridotti a pura rappresentazione.

Forse l’enorme dibattito che si è venuto a creare non era nemmeno negli obiettivi di Dartmouth, ma ha fornito un aiuto indispensabile nel capire che cosa possiamo chiedere a un calcolatore e che cosa rimane prerogativa esclusivamente umana.

[1] A proposito del suo coinvolgimento nel progetto di costruzione della bomba atomica e dell’odio verso nazisti, giapponesi e sovietici che sfocerà nella sua proposta di un bombardamento preventivo dell’Unione Sovietica.

[2] McCarthy, J., Minsky, M.L., Rochester, N., Shannon, C.E., A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence – august 31, 1955, “AI Magazine”, 2006, vol. XXVII, (4) – aaai.org

[3] L’A.M.Turing Award è un premio, assegnato annualmente dalla Association for Computing Machinery (ACM), ad una personalità che eccelle per i contributi di natura tecnica offerti alla comunità informatica, in particolare per progressi che siano duraturi e di elevata importanza tecnica.Il premio viene spesso anche chiamato “premio Nobel dell’informatica” (it.wikipedia.org).

[4] Cfr. Capponi, M., Il computer come ambiente di apprendimento, Perugia, Morlacchi, 2003, pp. 53-54.

Massimo Capponi è ricercatore Universitario Confermato all’Università di Perugia, insegna Informatica applicata all’educazione nel corso di laurea in Scienze dell’educazione.